在端侧AI(Edge AI)的浪潮中,大模型本地化已成为行业共识。然而,理想的算力需求与严苛的物理散热环境之间,始终存在着一道难以逾越的“功耗墙”。

01:边缘侧的“纸上算力”困局

走进任何一家AI硬件选型现场,“小体积、大算力”的口号比比皆是。但对于一线工程师而言,真正的痛点不在于芯片理论性能的高低,而在于实际部署的物理约束。市场上许多标榜高算力的GPU方案,在实验室环境下表现出色,但一旦进入紧凑的嵌入式设备或小型化盒子中,往往因功耗过大引发严重发热,导致频率骤降甚至系统宕机。

在近期参观AMD嵌入式峰会 并考察了主流ODM厂商的嵌入式x86小型PC方案后,我们发现:虽然目前各厂商的配置均已跟上时代,M.2接口已成为标准配置,但小体积依然是大家追逐的核心目标。

然而,这种极致的紧凑设计带来了不可避免的副作用——散热能力的妥协。受限于狭小的内部空间,这些设备难以支撑高功耗负载,其典型应用场景下的功耗支撑大多被锁死在3.3V,6.5A这一水平,多数设备甚至被限制在15W以下。这直接导致了大量端侧设备只能运行轻量化的小模型,无法触及认知智能的核心——大语言模型(LLM)。

02:架构创新:跨越9W TDP的性能奇迹

作为极具竞争优势的Edge AI GPU领先者,芯动力试图通过底层逻辑的革新来打破这一僵局。其自主研发的可重构并行处理器(RPP)架构,并未在传统GPU的能效死胡同里原地踏步,而是通过自主研发的架构,在有限的功耗预算内释放出了惊人的吞吐量。

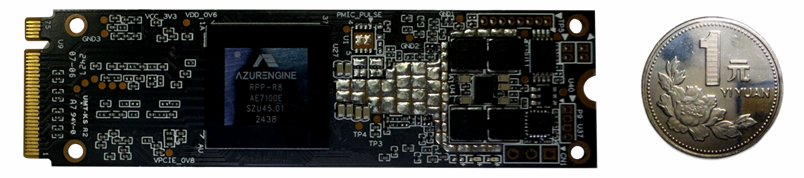

这种架构优势在芯动力新一代M.2加速卡上得到了集中体现。在仅有17mm×17mm的芯片尺寸内,芯动力不仅提供了32 TOPS的澎湃算力和60GB/s的内存带宽,更实现了一个极具里程碑意义的指标:仅需9W的TDP(热设计功耗),即可流畅支撑8B参数量级的大语言模型(LLM)。

对于行业而言,这2.5W(从6.5W到9W)的跨越并非简单的数值增长,而是本质的跨阶——它标志着AI加速卡终于在不破坏物理约束的前提下,让边缘设备具备了运行主流大模型的能力。

03:占领AI PC与AI NAS的先发高地

这种高能效比的突破,让芯动力在多个极具潜力的端侧赛道中占据了独特的先发优势。在AI PC领域,芯动力M.2加速卡让轻薄本摆脱了云端依赖,用户可以在本地隐私受保护的环境下,实时调用Llama 3、DeepSeek或通义千问等模型。得益于RPP架构对功耗的动态精准调控,设备在释放原有显卡压力的同时,大幅提升了整体续航与响应速度。

04:方寸之间,智启未来

当边缘计算进入深水区,算力的竞争已演变为能效与部署效率的竞争。芯动力凭借RPP架构对物理极限的挑战,不仅解决了算力和功耗的行业痛点,更在端侧AI的爆发前夜,为行业提供了一个真正可落地的技术范式。